某一天,好奇用了许久的截图软件 ocr 功能是如何实现的,于是打开 ida 走上了两天的不归之路()

本文仅供参考,学习逆向

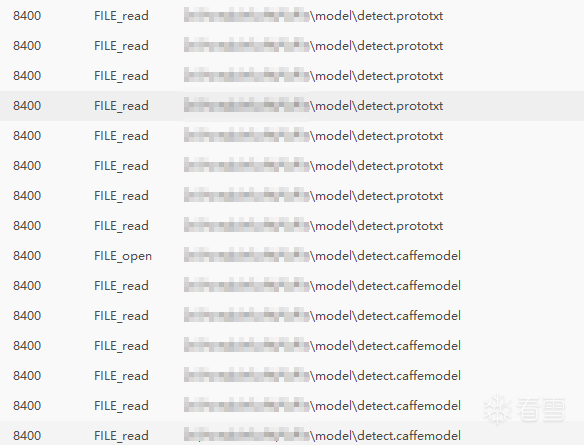

首先使用 Process Monitor 或者 火绒剑 等监视工具查看该软件文件相关的操作,我们可以看到在截图时这个软件在读取以下文件

但是通过互联网搜索我们可以知道这几个文件是关于 qrcode 也就是二维码识别有关的,不要被带偏

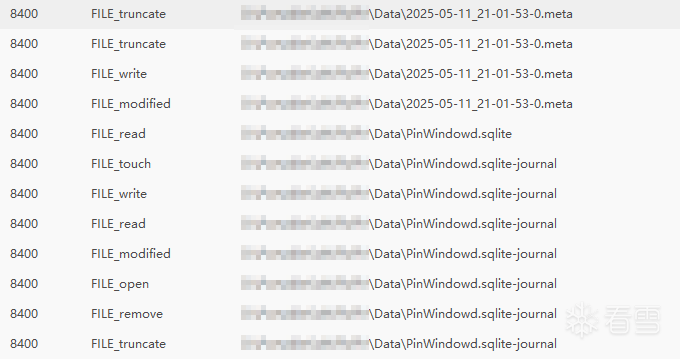

而当我们点击识别图像,也就是 ocr 操作的时候,他会读取以下内容

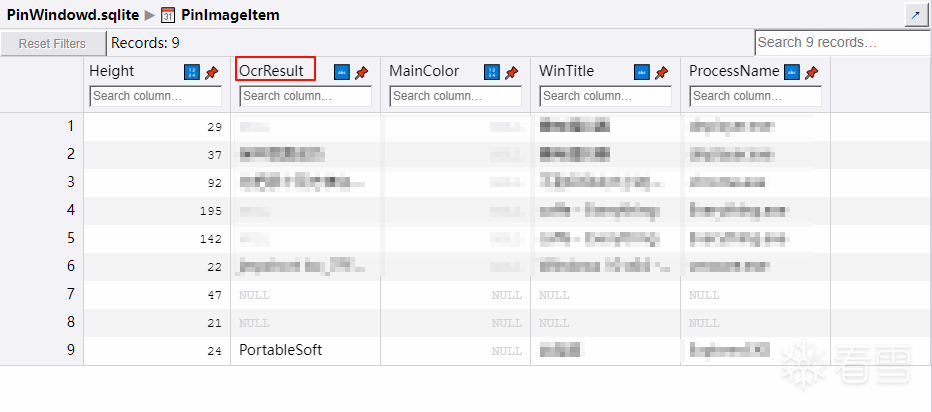

很明显这是一个 sqlite 数据库文件,我们看看里面有什么

里面有个 OcrResult 的字段引起了我的关注,至此信息收集就完毕了

拖入 ida,搜索 OcrResult 字符串,就两个结果,并且很容易猜出来上面一个是有关 sqlite 创建的

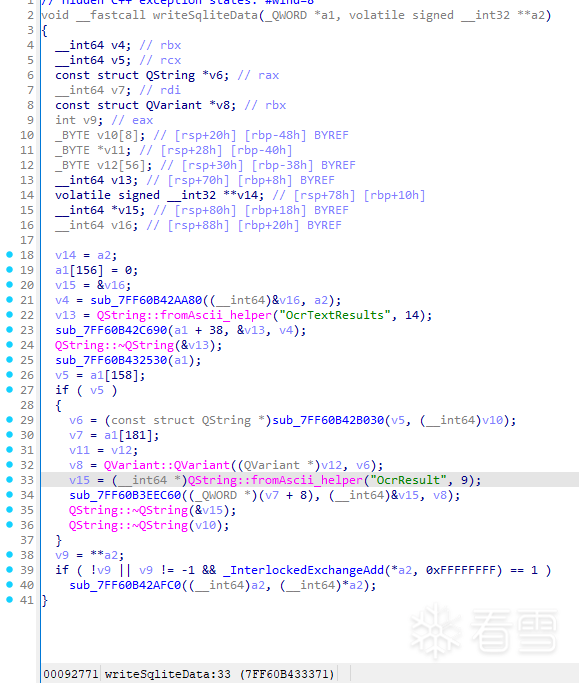

查看第二个字符串的引用,可以猜测这里是 sqlite 的写入

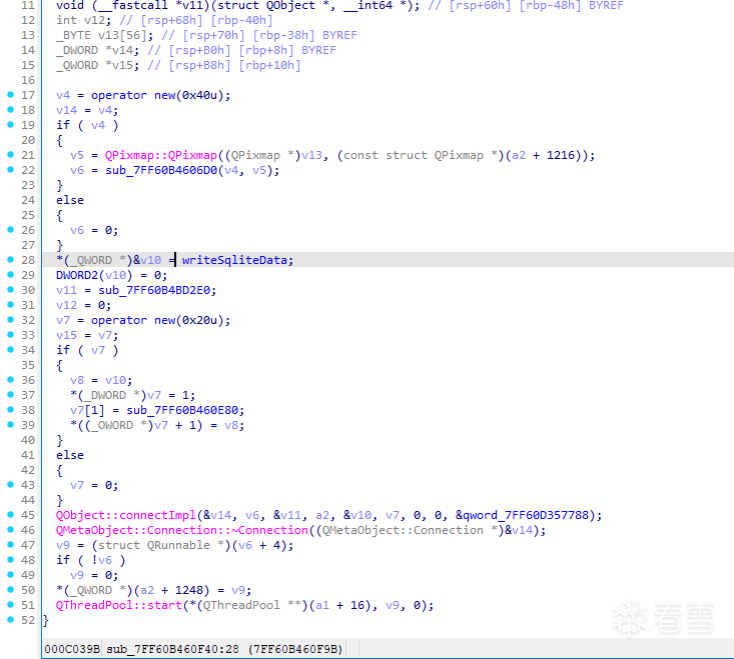

看该函数的上层,上面 sub_7FF60B4606D0 很明显是一个类的创建,进去看看

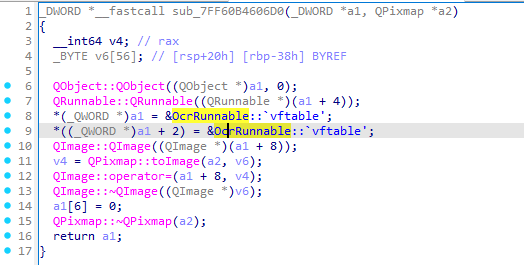

看看发现了什么,这正是我们要找的 ocr 功能相关的类

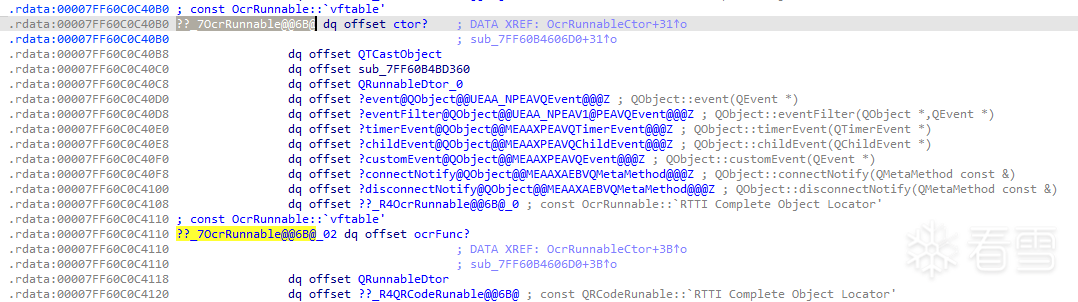

通过分析该类的 vftable 我们大概可以猜出各个函数的名称

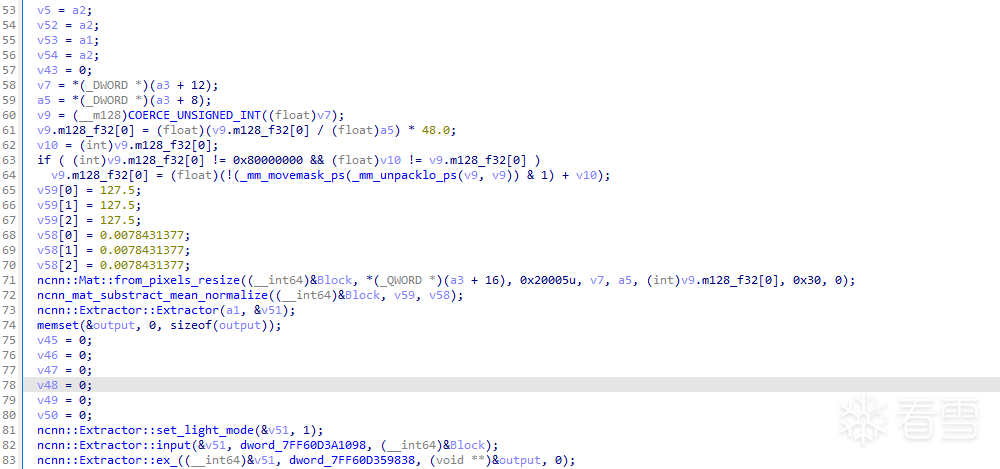

其中有个函数长这样,有很多图片相关的操作引起了我的注意

也就是上图中的 ??_7OcrRunnable@@6B@_02 dq offset ocrFunc? (这个函数我自己重命名了)

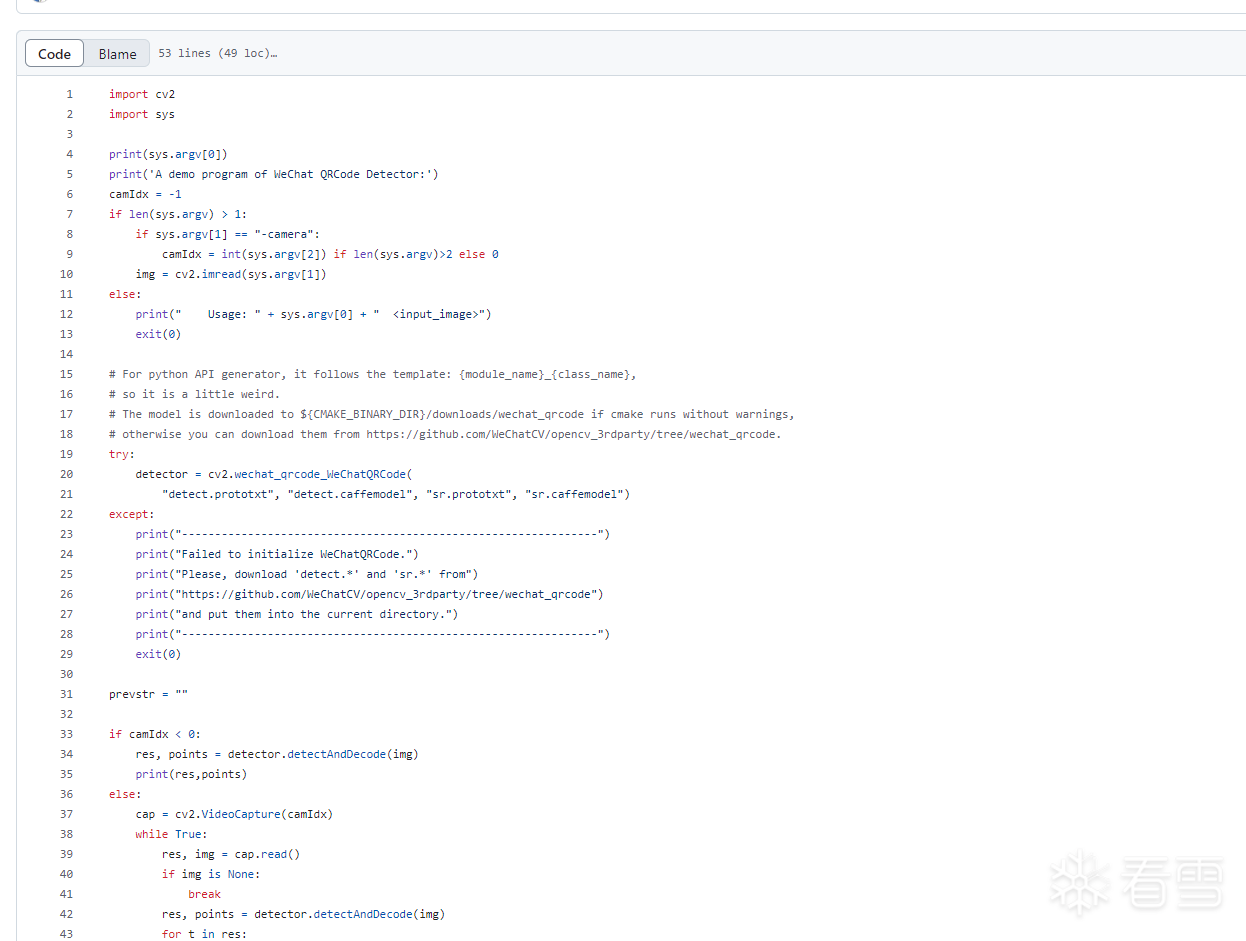

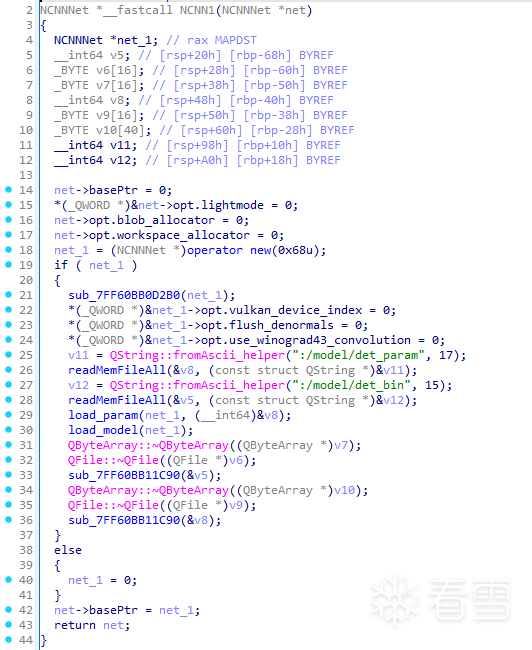

然后就是一个一个对函数进行猜测然后重命名,其中里面有一个函数似乎读取了模型,但是我们并搜不到该文件,答案是这个是一个 qt 的资源类型,qt 会将他打包在程序中,需要用到的时候从程序中读取出来,所以我们直接在 readMemFileAll 之后断点就能截取到数据啦

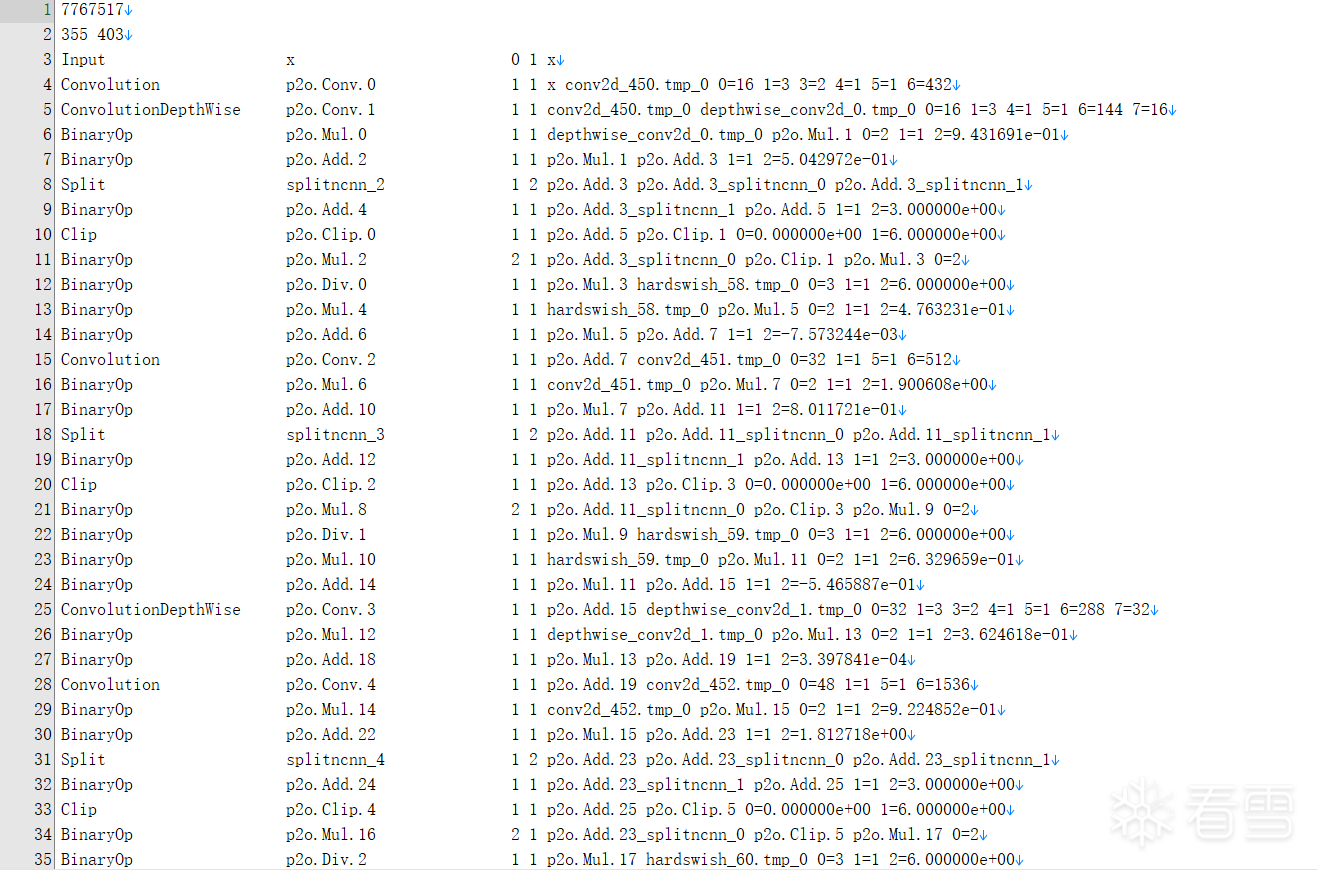

通过询问 ai ,我们可以知道这个文件可能是 ncnn 的格式文件,所以我们直接猜测该程序使用 ncnn 作为框架,进行 ocr 的识别

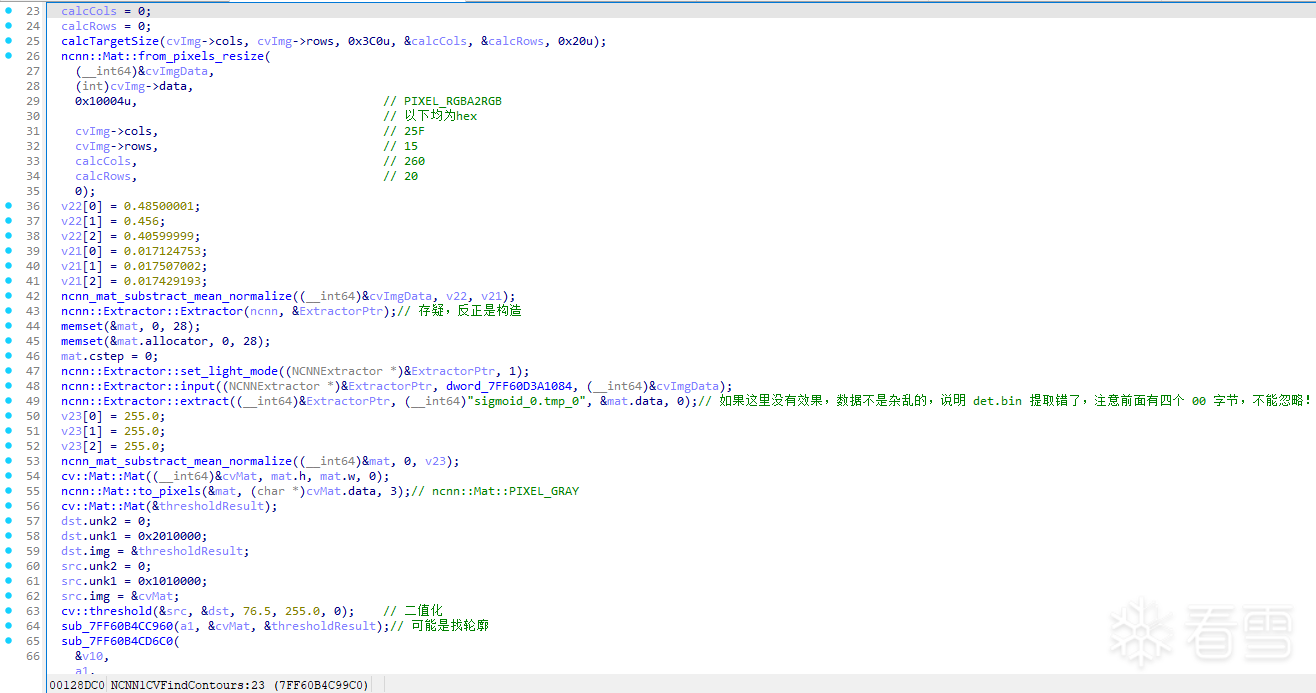

通过分析,大概的流程长这样,然后还有一些对于图像的操作,找模型识别出来的轮廓、找出文本区域

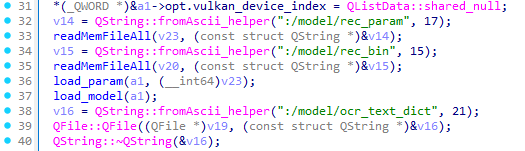

接着,程序会加载第二个 ai 模型来识别文本,而前一个模型是用来找出哪些区域需要识别文本的,其中 ocr_text_dict 为字典

ai 模型调用部分和上面一样,最后会输出一堆 float 的数组

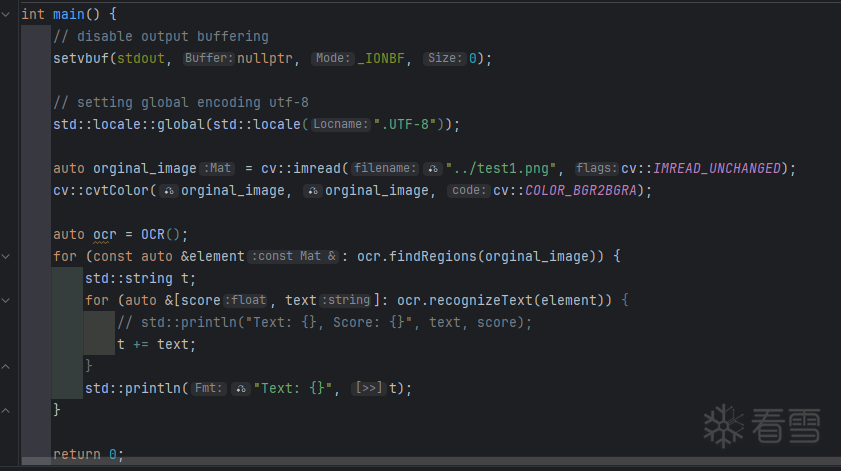

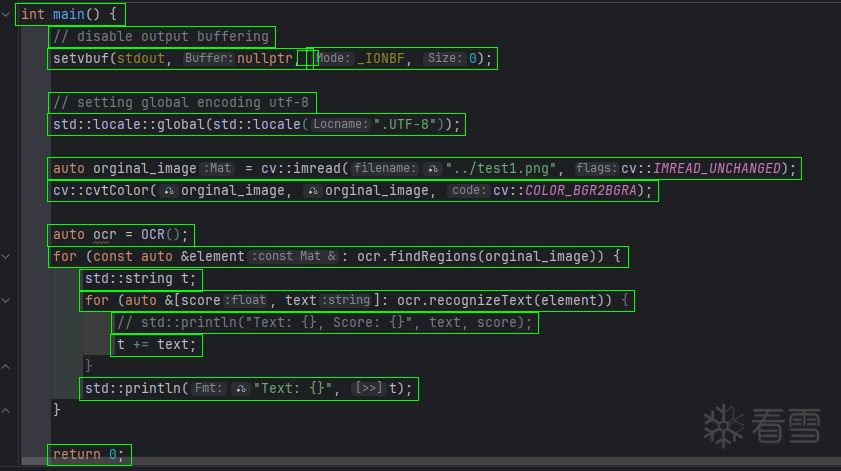

最后输出识别的文本比较麻烦,它主要长这样,通过分析,我们能够猜测和跟踪得出源代码差不多长这样

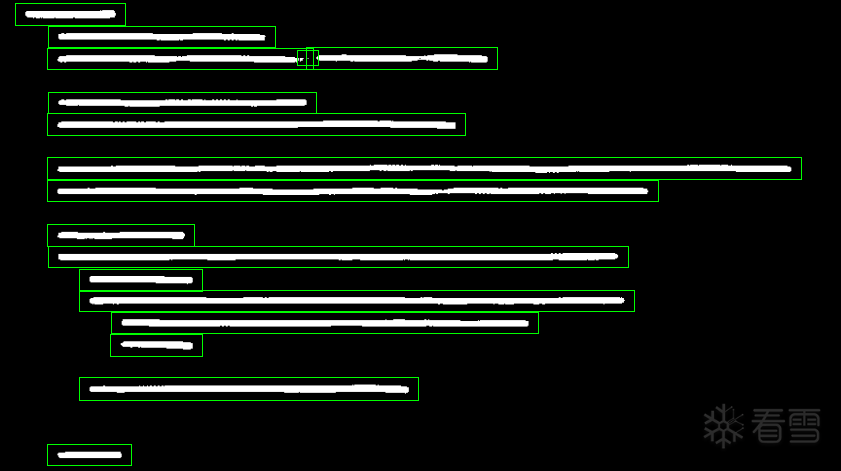

识别结果

调试效果图(当然 cv 操作不一定是对的,是自己写的)

改了下最后的代码,第二次 resize 的定值忘记改了,目前还是在想怎么匹配第一个模型找的区域对应的文本

改完代码,能用(应该),然后上传模型附件

添加效果图

#include <algorithm>

#include <array>

#include <cassert>

#include <print>

#include <string>

#include <vector>

#include "Utils.h"

#include <opencv2/opencv.hpp>

#include "net.h"

#define DetectParamPath "../data/det.param"

#define DetectModelPath "../data/det.bin"

#define RecognizeParamPath "../data/rec.param"

#define RecognizeModelPath "../data/rec.bin"

#define CharDictPath "../data/ocr_text_dict.txt"

#define IsDebug 1

namespace Impl {

uint64_t calcTargetSize(uint32_t cols, uint32_t rows, uint32_t *outCols, uint32_t *outRows, uint32_t maxSideConstraint, uint32_t alignment) {

unsigned int *v7;

if (cols < maxSideConstraint && rows < maxSideConstraint) {

maxSideConstraint = cols;

if (cols < rows)

maxSideConstraint = rows;

if (maxSideConstraint % alignment)

maxSideConstraint += alignment - maxSideConstraint % alignment;

}

if (rows <= cols) {

*outCols = maxSideConstraint;

v7 = outRows;

*outRows = maxSideConstraint * rows / cols;

} else {

v7 = outRows;

*outRows = maxSideConstraint;

*outCols = maxSideConstraint * cols / rows;

}

unsigned int v8 = *outCols % alignment;

if (v8)

*outCols = alignment + *outCols - v8;

unsigned int v10 = *v7 % alignment;

uint64_t result = *v7 / alignment;

if (v10)

*v7 = alignment + *v7 - v10;

return result;

}

std::vector<cv::Mat> getEachRegion(const cv::Mat &image, const cv::Mat &binaryMask) {

cv::Mat newBinary = binaryMask.clone();

cv::resize(newBinary, newBinary, cv::Size(image.cols, image.rows));

std::vector<std::vector<cv::Point> > contours;

std::vector<cv::Vec4i> hierarchy;

cv::findContours(newBinary, contours, hierarchy, cv::RETR_EXTERNAL, cv::CHAIN_APPROX_SIMPLE);

#if IsDebug

cv::cvtColor(newBinary, newBinary, cv::COLOR_GRAY2BGR);

cv::Mat debugImageBinary = newBinary.clone();

cv::Mat debugImage = image.clone();

#endif

std::vector<cv::Mat> cropped_images;

constexpr int padding_x = 10;

constexpr int padding_y = 7;

constexpr int min_area = 4;

std::println("find contours: {}", contours.size());

for (size_t i = 0; i < contours.size(); ++i) {

cv::Rect original_box = cv::boundingRect(contours[i]);

if (original_box.area() < min_area) {

std::println("area too small: {}", original_box.area());

continue;

}

cv::Rect expanded_box;

expanded_box.x = std::ranges::max(0, original_box.x - padding_x);

expanded_box.y = std::ranges::max(0, original_box.y - padding_y);

expanded_box.width = std::ranges::min(image.cols - expanded_box.x, original_box.width + padding_x * 2);

expanded_box.height = std::ranges::min(image.rows - expanded_box.y, original_box.height + padding_y * 2);

if (expanded_box.width <= 0 || expanded_box.height <= 0) {

std::println("Skipping contour {} because expanded box is invalid.", i);

continue;

}

#if IsDebug

cv::rectangle(debugImage, expanded_box, cv::Scalar(0, 255, 0, 255), 1);

cv::rectangle(debugImageBinary, expanded_box, cv::Scalar(0, 255, 0, 255), 1);

#endif

cv::Mat cropped_region = image(expanded_box).clone();

cropped_images.emplace_back(cropped_region);

}

#if IsDebug

cv::imwrite("../output/debugImage.png", debugImage);

cv::imwrite("../output/debugImageBinary.png", debugImageBinary);

#endif

return cropped_images;

}

}

class OCR {

private:

ncnn::Net detectNet_;

ncnn::Net recognizeNet_;

std::vector<std::string> charDict_;

public:

OCR() {

detectNet_.load_param(DetectParamPath);

detectNet_.load_model(DetectModelPath);

recognizeNet_.load_param(RecognizeParamPath);

recognizeNet_.load_model(RecognizeModelPath);

charDict_ = Utils::getCharDict(CharDictPath);

}

std::vector<cv::Mat> findRegions(const cv::Mat &image) {

assert(image.type() == CV_8UC4 && "image type must be CV_8UC4(BGRA)");

unsigned int calcCols, calcRows;

Impl::calcTargetSize(image.cols, image.rows, &calcCols, &calcRows, 0x3C0u, 0x20u);

ncnn::Mat out;

ncnn::Mat in = ncnn::Mat::from_pixels_resize(

image.data,

ncnn::Mat::PIXEL_RGBA2RGB,

image.cols,

image.rows,

static_cast<int>(calcCols),

static_cast<int>(calcRows)

);

uint32_t mean_vals[3];

uint32_t norm_vals[3];

mean_vals[0] = 0x3EF851EC;

mean_vals[1] = 0x3EE978D5;

mean_vals[2] = 0x3ECFDF3B;

norm_vals[0] = 0x3C8C4936;

norm_vals[1] = 0x3C8F6AD8;

norm_vals[2] = 0x3C8EC7AB;

in.substract_mean_normalize(reinterpret_cast<float *>(mean_vals), reinterpret_cast<float *>(norm_vals));

ncnn::Extractor ex = detectNet_.create_extractor();

ex.input("x", in);

ex.extract("sigmoid_0.tmp_0", out, 0);

uint32_t norms2[3];

norms2[0] = 0x437F0000;

norms2[1] = 0x437F0000;

norms2[2] = 0x437F0000;

out.substract_mean_normalize(nullptr, reinterpret_cast<float *>(norms2));

cv::Mat binaryMask(out.h, out.w, CV_8U);

out.to_pixels(binaryMask.data, ncnn::Mat::PIXEL_GRAY);

cv::threshold(binaryMask, binaryMask, 76.5, 255.0, cv::THRESH_BINARY);

assert(binaryMask.type() == CV_8UC1 && "mask type must be CV_8UC1");

return Impl::getEachRegion(image, binaryMask);

}

std::vector<std::pair<float, std::string> > recognizeText(const cv::Mat &image) {

assert(image.type() == CV_8UC4 && "image type must be CV_8UC4(BGRA)");

ncnn::Mat out2;

ncnn::Mat in2 = ncnn::Mat::from_pixels_resize(

image.data,

ncnn::Mat::PIXEL_BGRA2BGR,

image.cols,

image.rows,

static_cast<int>(static_cast<float>(image.cols) / static_cast<float>(image.rows) * 48.0),

0x30

);

constexpr uint32_t mean_vals2[3] { 0x42FF0000, 0x42FF0000, 0x42FF0000 };

constexpr uint32_t norm_vals2[3] { 0x3C008081, 0x3C008081, 0x3C008081 };

in2.substract_mean_normalize(reinterpret_cast<const float *>(mean_vals2), reinterpret_cast<const float *>(norm_vals2));

ncnn::Extractor extractor = recognizeNet_.create_extractor();

extractor.input("x", in2);

extractor.extract("softmax_11.tmp_0", out2, 0);

std::vector<std::pair<float, std::string> > results;

int64_t lastIndex = 0;

for (int hIndex = 0; hIndex < out2.h; ++hIndex) {

const auto l1 = out2.row(hIndex);

const auto l2 = out2.row(hIndex + 1);

const auto maxElementPtr = std::ranges::max_element(l1, l2);

const auto index = maxElementPtr - l1;

if (index > 0 && (hIndex <= 0 || index != lastIndex)) {

results.emplace_back(*maxElementPtr, charDict_[index - 1]);

}

lastIndex = index;

}

return results;

}

};

int main() {

auto orginal_image = cv::imread("../test1.png", cv::IMREAD_UNCHANGED);

cv::cvtColor(orginal_image, orginal_image, cv::COLOR_BGR2BGRA);

auto ocr = OCR();

for (const auto &element: ocr.findRegions(orginal_image)) {

std::string t;

for (auto &[score, text]: ocr.recognizeText(element)) {

t += text;

}

std::println("Text: {}", t);

}

return 0;

}

#include <algorithm>

#include <array>

#include <cassert>

#include <print>

#include <string>

#include <vector>

#include "Utils.h"

#include <opencv2/opencv.hpp>

#include "net.h"

#define DetectParamPath "../data/det.param"

#define DetectModelPath "../data/det.bin"

#define RecognizeParamPath "../data/rec.param"

#define RecognizeModelPath "../data/rec.bin"

#define CharDictPath "../data/ocr_text_dict.txt"

#define IsDebug 1

namespace Impl {

uint64_t calcTargetSize(uint32_t cols, uint32_t rows, uint32_t *outCols, uint32_t *outRows, uint32_t maxSideConstraint, uint32_t alignment) {

unsigned int *v7;

if (cols < maxSideConstraint && rows < maxSideConstraint) {

maxSideConstraint = cols;

if (cols < rows)

maxSideConstraint = rows;

if (maxSideConstraint % alignment)

maxSideConstraint += alignment - maxSideConstraint % alignment;

}

if (rows <= cols) {

*outCols = maxSideConstraint;

v7 = outRows;

*outRows = maxSideConstraint * rows / cols;

} else {

v7 = outRows;

*outRows = maxSideConstraint;

*outCols = maxSideConstraint * cols / rows;

}

unsigned int v8 = *outCols % alignment;

if (v8)

*outCols = alignment + *outCols - v8;

unsigned int v10 = *v7 % alignment;

uint64_t result = *v7 / alignment;

if (v10)

*v7 = alignment + *v7 - v10;

return result;

}

std::vector<cv::Mat> getEachRegion(const cv::Mat &image, const cv::Mat &binaryMask) {

cv::Mat newBinary = binaryMask.clone();

cv::resize(newBinary, newBinary, cv::Size(image.cols, image.rows));

std::vector<std::vector<cv::Point> > contours;

std::vector<cv::Vec4i> hierarchy;

cv::findContours(newBinary, contours, hierarchy, cv::RETR_EXTERNAL, cv::CHAIN_APPROX_SIMPLE);

#if IsDebug

cv::cvtColor(newBinary, newBinary, cv::COLOR_GRAY2BGR);

cv::Mat debugImageBinary = newBinary.clone();

cv::Mat debugImage = image.clone();

#endif

std::vector<cv::Mat> cropped_images;

constexpr int padding_x = 10;

constexpr int padding_y = 7;

constexpr int min_area = 4;

std::println("find contours: {}", contours.size());

for (size_t i = 0; i < contours.size(); ++i) {

cv::Rect original_box = cv::boundingRect(contours[i]);

if (original_box.area() < min_area) {

std::println("area too small: {}", original_box.area());

continue;

}

cv::Rect expanded_box;

expanded_box.x = std::ranges::max(0, original_box.x - padding_x);

expanded_box.y = std::ranges::max(0, original_box.y - padding_y);

expanded_box.width = std::ranges::min(image.cols - expanded_box.x, original_box.width + padding_x * 2);

expanded_box.height = std::ranges::min(image.rows - expanded_box.y, original_box.height + padding_y * 2);

if (expanded_box.width <= 0 || expanded_box.height <= 0) {

std::println("Skipping contour {} because expanded box is invalid.", i);

continue;

}

#if IsDebug

cv::rectangle(debugImage, expanded_box, cv::Scalar(0, 255, 0, 255), 1);

cv::rectangle(debugImageBinary, expanded_box, cv::Scalar(0, 255, 0, 255), 1);

#endif

cv::Mat cropped_region = image(expanded_box).clone();

cropped_images.emplace_back(cropped_region);

}

#if IsDebug

cv::imwrite("../output/debugImage.png", debugImage);

[培训]科锐逆向工程师培训第53期2025年7月8日开班!

最后于 2025-5-15 10:39

被mb_jepgtozh编辑

,原因: